Retrieval-Augmented Generation (RAG) ist zu einem unverzichtbaren Werkzeug für Unternehmen geworden, die das Potenzial von unstrukturiertem Wissen erschließen wollen. Durch die Kombination von Retrieval mit generativer KI ermöglichen RAG-Systeme Unternehmen die Beantwortung komplexer Anfragen, die Zusammenfassung umfangreicher Daten und die Bereitstellung kontextrelevanter Erkenntnisse. Trotz ihrer vielversprechenden Möglichkeiten sind die RAG-Pipelines jedoch oft unzureichend, da sie in den Phasen der Abfrage, der Erweiterung und der Generierung an ihre Grenzen stoßen.

In diesem Beitrag stellen wir dir praktische Schritte vor, mit denen du gängige RAG-Herausforderungen meistern und robuste Pipelines aufbauen kannst, die die Grenzen von RAG überwinden. Diese grundlegenden Techniken – die Diversifizierung des Retrievals, die Kombination von semantischer und Stichwortsuche und das Reranking – sollen dir helfen, die Leistung deines RAG-Systems zu optimieren. Diese RAG-Optimierungstechniken bieten schnelle, kosteneffiziente und wirkungsvolle Lösungen, die auch mit kleineren Modellen zugänglich sind. Wenn du tiefer in die technischen Details eintauchen willst, schau dir das begleitende Workshop-Video und das GitHub-Repository an.

Herausforderungen in RAG-Pipelines

RAG-Pipelines sind nur so stark wie ihre schwächste Phase. Obwohl ihre innovative Architektur Abruf und Erzeugung kombiniert, stoßen naive Implementierungen oft auf große Herausforderungen:

- Probleme bei der Datenbeschaffung: Irrelevante, redundante oder unvollständige Daten, die mit einfachen Methoden abgerufen werden.

- Erweiterungslücken: Schlechte kontextuelle Anpassung, die Rohdaten und differenzierte Abfragen nicht miteinander verbindet.

- Unzulänglichkeiten bei der Erzeugung: Irreführende, unvollständige oder kontextbezogene Ergebnisse, die durch fehlerhafte Eingaben verursacht werden.

Die Folgen dieser Einschränkungen ziehen sich durch die gesamte Unternehmenslandschaft und führen zu langsameren Entscheidungen, geringerer Kundenzufriedenheit und verpassten Compliance-Anforderungen. Die Bewältigung dieser Herausforderungen beginnt mit der Verfeinerung der Abruf- und Erweiterungsphasen, den grundlegenden Schichten eines jeden RAG-Systems.

Praktische Schritte zur Überwindung der RAG-Beschränkungen

Schritt 1: Diversifizierung der Abfrageergebnisse mit MMR

Maximal Marginal Relevance (MMR) ist eine Technik, die ein Gleichgewicht zwischen Relevanz und Vielfalt in den abgerufenen Dokumenten herstellt. Indem sie eine übermäßige Ähnlichkeit zwischen den Ergebnissen vermeidet, stellt MMR sicher, dass deine Pipeline ein breiteres Spektrum an nützlichen Informationen erfasst.

- Wie es funktioniert: MMR ordnet Dokumente nicht nur nach ihrer Relevanz für die Suchanfrage ein, sondern auch nach ihrer Neuheit im Vergleich zu bereits ausgewählten Dokumenten.

- Praktische Auswirkungen: Reduziert die Redundanz in den abgerufenen Dokumenten und verbessert so die Gesamtqualität des abgerufenen Kontexts.

Schritt 2: Kombiniere semantische und stichwortbasierte Suche mit Hybrid Retrieval

Hybrid Retrieval kombiniert zwei leistungsstarke Methoden: BM25 für schlagwortbasierte Relevanz und Embeddings für semantische Ähnlichkeit. Diese Kombination stellt sicher, dass deine Pipeline Dokumente findet, die sowohl topisch relevant als auch kontextuell reichhaltig sind.

- So funktioniert es: BM25 bewertet Dokumente auf der Grundlage von exakten Termübereinstimmungen, während Einbettungen tiefere Beziehungen durch Vektorähnlichkeit erfassen.

- Praktische Auswirkungen: Erhöht die Treffergenauigkeit durch die Erfassung von domänenspezifischer Terminologie und breiterer kontextueller Relevanz.

Schritt 3: Priorisiere Top-Ergebnisse mit Reranking

Beim Reranking werden fortschrittliche maschinelle Lernmodelle, wie z.B. Cross-Encoder, eingesetzt, um die abgerufenen Dokumente auf der Grundlage ihrer kontextuellen Relevanz neu zu ordnen. Dieser Schritt konzentriert sich darauf, die wichtigsten Dokumente an die Spitze zu bringen.

- So funktioniert es: Ein Cross-Encoder bewertet die Beziehung zwischen der Anfrage und jedem Dokument und vergibt eine Relevanzbewertung.

- Praktische Auswirkungen: Stellt sicher, dass die besten Ergebnisse die wertvollsten für die Beantwortung komplexer Abfragen sind, reduziert das Rauschen und verbessert die Genauigkeit.

Durch die Integration dieser drei Schritte können RAG-Pipelines die Herausforderungen beim Retrieval direkt angehen und die Grundlage für eine bessere Augmentation und Generierung legen.

Warum diese Schritte wichtig sind

Diese praktischen Verfeinerungen sind einfach, aber sehr effektiv. Im Gegensatz zu fortschrittlichen Generierungstechniken, die erhebliche Rechenressourcen erfordern, ist die Verbesserung des Abrufs kosteneffizient und skalierbar. Unternehmen, die kleinere Modelle verwenden, können mit diesen Schritten präzise und zuverlässige Ergebnisse liefern, ohne die bestehende Infrastruktur zu überholen.

Fallstudie: Workshop-Rekapitulation

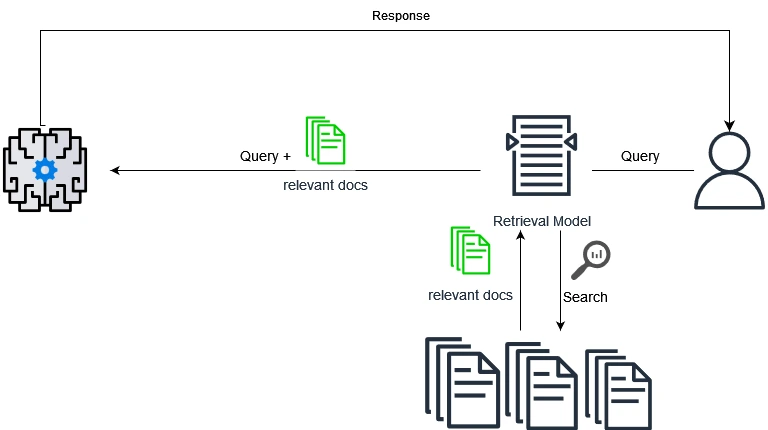

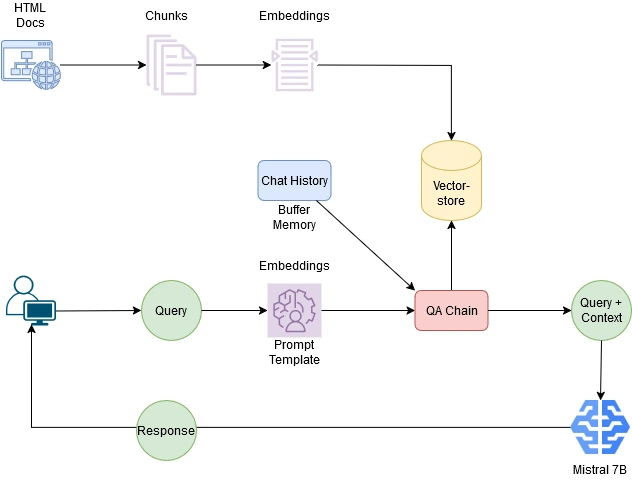

Auf unserem letzten Workshop haben wir gezeigt, wie diese grundlegenden Techniken die Leistung von RAG verbessern. Anhand eines 7-Milliarden-Parameter-Modells haben wir eine RAG-Pipeline optimiert, um reale Transformatorenspezifikationen zu verarbeiten. Durch die Verbesserung der Suchvielfalt, die Kombination hybrider Methoden und das Reranking der Ergebnisse lieferte die Pipeline präzise und kontextgenaue Antworten – trotz der Beschränkungen des kleineren Modells. Das folgende Diagramm gibt einen Überblick über die Pipeline-Architektur, die wir während des Workshops verwendet haben:

Erläuterung des Diagramms:

- Dokumentenverarbeitung: Rohdokumente (z. B. PDF- oder HTML-Dateien) werden gechunked und zur Speicherung in eine Vektordatenbank eingebettet.

- Abrufverfahren: Wenn ein Nutzer eine Anfrage stellt, werden relevante Chunks mit Techniken wie MMR, Hybrid Retrieval und Reranking abgerufen.

- Generierungsphase: Der ermittelte Kontext wird zusammen mit der Abfrage an die QA-Kette weitergeleitet, um mithilfe des Sprachmodells Antworten zu generieren.

- Zusätzliche Komponenten:

- Der Pufferspeicher speichert den Chatverlauf für den Gesprächskontext.

- Die QS-Kette verwendet eine anpassbare Prompt-Vorlage, um die Eingaben für das Modell zu formatieren.

Eine der wichtigsten Erkenntnisse aus unserem Workshop war, dass RAG-Pipelines nur so stark sind wie ihre schwächste Phase. Die Optimierung des Abrufs und der Erweiterung bildet eine solide Grundlage für genaue und verlässliche Ergebnisse, selbst wenn kleinere Modelle verwendet werden.

Die wichtigsten Erkenntnisse aus dem Workshop:

- Herausforderungen in der RAG:

- Abrufen von irrelevanten, redundanten oder unvollständigen Daten.

- Schlechte Kontextualisierung der abgerufenen Informationen.

- Sie erzeugen unvollständige oder irreführende Ergebnisse.

- Pipeline-Optimierung:

- Verbesserungen in der Einbettungs- und Abrufphase sind einfacher, kostengünstiger und sehr wirkungsvoll.

- Wir haben unter anderem folgende Techniken untersucht:

- MMR: Diversifiziert die Abfrageergebnisse.

- Hybrid Retrieval: Kombiniert Suchbegriffsrelevanz mit semantischer Ähnlichkeit für eine bessere Genauigkeit.

- Reranking: Hebt die relevantesten Inhalte für mehr Präzision an.

- Gelernte Lektionen:

- Die Qualität des Abrufs ist die Grundlage für den Erfolg der RAG.

- Inkrementelle Optimierungen führen zu erheblichen Gewinnen.

- Die Kombination von Strategien verbessert sowohl die Relevanz als auch die Genauigkeit der Ergebnisse.

- Optimierte Pipelines ermöglichen es kleineren Modellen, auf effiziente Weise präzise, kontextbezogene Antworten zu liefern.

Für eine praktische Demonstration kannst du dir das Workshop-Video ansehen oder das GitHub-Repository mit dem gesamten Code und den Beispielen erkunden.

Ausblick auf zukünftige Techniken

Während die hier behandelten Schritte eine solide Grundlage bilden, ist die RAG-Optimierung eine kontinuierliche Reise. Fortgeschrittene Techniken wie Query Rewriting, Reflective RAG und agentische RAG-Systeme versprechen noch größere Verbesserungen bei der Bearbeitung komplexer Abfragen und dynamischer Kontexte. Bleib dran für zukünftige Beiträge, in denen wir uns mit diesen innovativen Ansätzen beschäftigen werden.

Fazit

Die Optimierung von RAG-Pipelines muss nicht überwältigend sein. Indem sie mit einfachen Schritten wie MMR, Hybrid Retrieval und Reranking beginnen, können Unternehmen die Leistung ihrer Systeme erheblich steigern. Diese Verbesserungen sind nicht nur kosteneffizient, sondern bringen auch messbare geschäftliche Vorteile in Bezug auf Genauigkeit, Geschwindigkeit und Kundenzufriedenheit.

Schau dir das Workshop-Video und das GitHub-Repository an, um den nächsten Schritt beim Aufbau einer robusten RAG-Pipeline für dein Unternehmen zu machen.

Danksagung

Dieser Workshop wurde in Zusammenarbeit mit KI Park organisiert, wo wir praktische Schritte zur Optimierung von RAG-Pipelines untersuchten. Unser besonderer Dank gilt KI Park für die Organization der Veranstaltung und die Bereitstellung des Videos auf ihrem Kanal. Der Workshop beinhaltete auch eine aufschlussreiche Session über Multimodale RAG-Techniken, die von Taras Hnot von SoftServe präsentiert wurde. Sein Fachwissen über die Kombination von Retrieval mit multimodalen Fähigkeiten vermittelte einen umfassenden Einblick in das Potenzial von RAG in verschiedenen Anwendungen.